В этом посте будет показан процесс создания приложений LangChain с использованием шаблона подсказки и анализатора вывода.

Как создавать приложения LangChain с использованием шаблона подсказки и анализатора вывода?

Чтобы создать приложение LangChain с использованием шаблона приглашения и анализатора вывода, просто следуйте этому простому руководству:

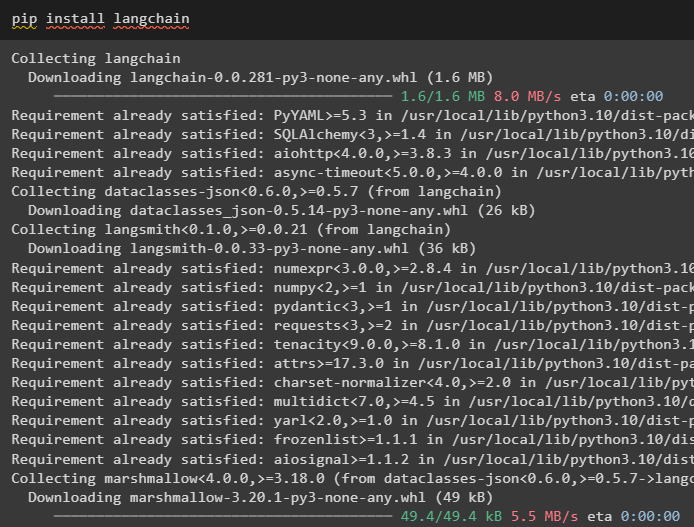

Шаг 1. Установите Лангчейн

Сначала запустите процесс создания приложений LangChain, установив инфраструктуру LangChain, используя « пункт » команда:

pip установить langchain

Шаг 2. Использование шаблона приглашения

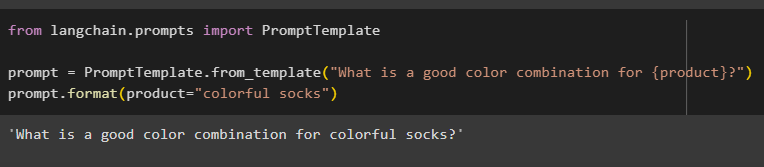

После установки модулей LangChain импортируйте файл « Шаблон приглашения » для создания шаблона подсказки, предоставив модели запрос, позволяющий понять вопрос:

из langchain.prompts импорт PromptTemplate

подсказка = PromptTemplate.from_template('Какое сочетание цветов подойдет для {продукта}?')

Prompt.format(product='красочные носки')

Вывод автоматически объединил предложение со значением « продукт ' переменная:

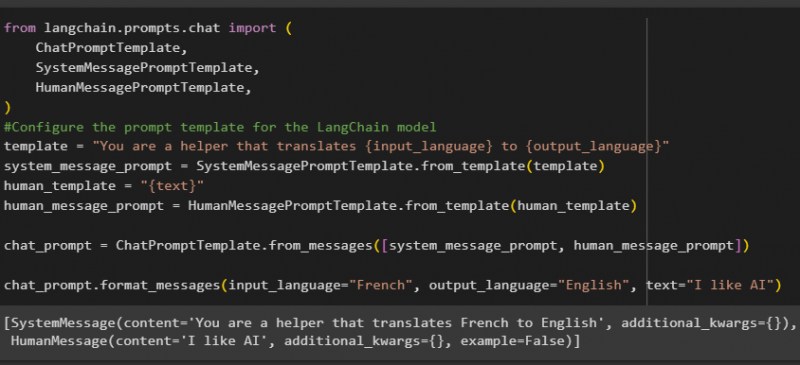

После этого создайте еще один шаблон приглашения, импортировав библиотеки HumanMessagePromptTemplate, ChatPromptTemplate и SystemMessagePromptTemplate из LangChain:

из импорта langchain.prompts.chat (Шаблон запроса чата,

Шаблон системного сообщения,

Шаблон HumanMessagePrompt,

)

#Настраиваем шаблон приглашения для модели LangChain

template = 'Вы помогаете переводить {input_language} на {output_language}'

system_message_prompt = SystemMessagePromptTemplate.from_template(шаблон)

human_template = '{текст}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='Французский', output_language='Английский', text='Мне нравится ИИ')

После импорта всех необходимых библиотек просто создайте собственный шаблон для запросов, используя переменную шаблона:

Шаблоны подсказок используются только для установки шаблона запроса/вопроса и не дают никакого ответа на вопрос. Однако функция OutputParser() может извлекать ответы, как показано в следующем разделе на примере:

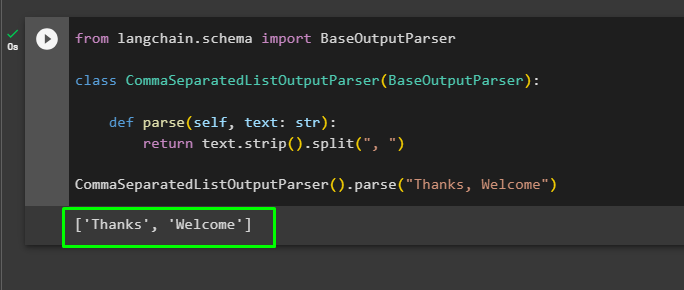

Шаг 3. Использование анализатора вывода

Теперь импортируйте библиотеку BaseOutputParser из LangChain, чтобы разделить текстовые значения, разделенные запятыми, и вернуть список на выходе:

из langchain.schema импортировать BaseOutputParserкласс CommaSeparatedListOutputParser(BaseOutputParser):

def parse(self, text: str):

вернуть text.strip().split(', ')

CommaSeparatedListOutputParser().parse('Спасибо, добро пожаловать')

Это все, что касается создания приложения LangChain с использованием шаблона приглашения и синтаксического анализатора вывода.

Заключение

Чтобы создать приложение LangChain с использованием шаблона приглашения и анализатора вывода, просто установите LangChain и импортируйте из него библиотеки. Библиотека PromptTemplate используется для построения структуры запроса, чтобы модель могла понять вопрос перед извлечением информации с помощью функции Parser(). Функция OutputParser() используется для получения ответов на основе ранее настроенных запросов. В этом руководстве объясняется процесс создания приложений LangChain с использованием шаблона приглашения и анализатора вывода.