Большие языковые модели или LLM — это мощный вид алгоритма нейронной сети для создания чат-ботов, которые извлекают данные с помощью команд на естественных языках. LLM позволяют машинам/компьютерам лучше понимать естественный язык и генерировать язык, как человек. Модуль LangChain также работает для построения моделей НЛП. Однако у него нет своего LLM, но он позволяет взаимодействовать со многими различными LLM.

В этом руководстве будет объяснен процесс взаимодействия с моделями большого языка с использованием LangChain.

Как взаимодействовать с LLM с помощью LangChain?

Чтобы взаимодействовать с LLM с помощью LangChain, просто следуйте этому простому пошаговому руководству с примерами:

Установите модули для взаимодействия с LLM

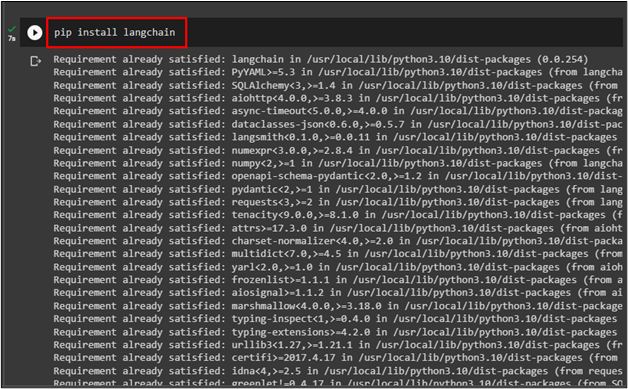

Прежде чем начать процесс взаимодействия с LLM с помощью LangChain, установите « Лангчейн », используя следующий код:

пункт установить Лангчейн

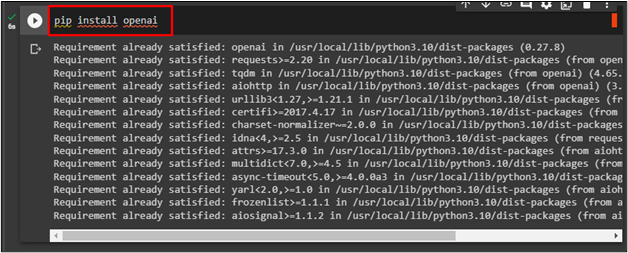

Чтобы установить платформу OpenAI, используйте ее ключ API для взаимодействия с LLM с помощью следующего кода:

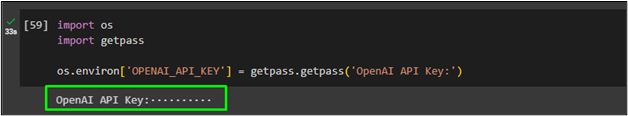

Теперь импортируйте « ты ' и ' получить пропуск », чтобы использовать ключ API OpenAI после выполнения кода:

импортируйте нас

импортировать getpass

os.environ [ 'OPENAI_API_KEY' ] = getpass.getpass ( «Ключ API OpenAI:» )

Звонок в LLM

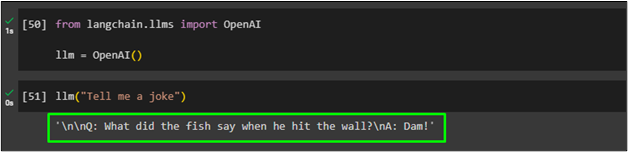

Импортируйте библиотеку OpenAI из модуля LangChain, чтобы назначить ее функцию « лм ' переменная:

из langchain.llms импортировать OpenAIллм = OpenAI ( )

После этого просто позвоните в « лм » и запрос подсказки в качестве ее параметра:

Создание нескольких текстов с использованием LLM

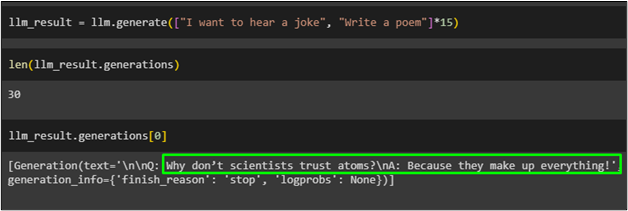

Используйте методgenerate() с несколькими подсказками на естественном языке, чтобы сгенерировать текст из LLM и сохранить его в файле « llm_result ' переменная:

llm_result = llm.generate ( [ «Я хочу услышать анекдот» , 'Написать поэму' ] * пятнадцать )

Получить длину объектов, хранящихся в « llm_result переменная с использованием функцииgenerate():

Просто вызовите переменную с порядковым номером объектов:

На следующем снимке экрана показан текст, хранящийся в папке « llm_result ” переменная с нулевым индексом, генерирующая шутку:

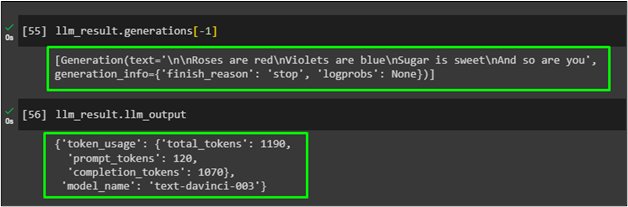

Используйте метод «Generations()» с параметром индекса -1, чтобы сгенерировать стихотворение, помещенное в переменную llm_result:

Просто отобразите сгенерированный результат в переменной результата, чтобы получить информацию, специфичную для поставщика, которая была сгенерирована в предыдущем LLM, с помощью сгенерированной функции:

Это все, что касается взаимодействия с LLM с использованием инфраструктуры LangChain для генерации естественного языка.

Заключение

Чтобы взаимодействовать с большими языковыми моделями с помощью LangChain, просто установите такие платформы, как LangChain и OpenAI, для импорта библиотек для LLM. После этого предоставьте ключ API OpenAI, который будет использоваться в качестве LLM для понимания или создания естественного языка. Используйте LLM для ввода подсказки на естественном языке, а затем вызовите ее для создания текста на основе команды. В этом руководстве объяснен процесс взаимодействия с моделями большого языка с использованием модулей LangChain.