Это руководство проиллюстрирует процесс использования графа знаний диалога в LangChain.

Как использовать диаграмму знаний диалога в LangChain?

РазговорKGПамять Библиотека может использоваться для воссоздания памяти, которую можно использовать для получения контекста взаимодействия. Чтобы изучить процесс использования графа знаний разговоров в LangChain, просто выполните перечисленные шаги:

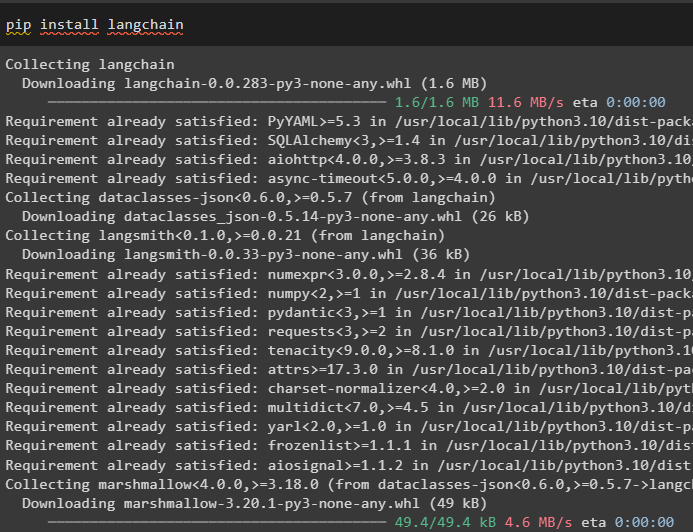

Шаг 1. Установите модули

Сначала начните использовать граф знаний диалога, установив модуль LangChain:

pip установить langchain

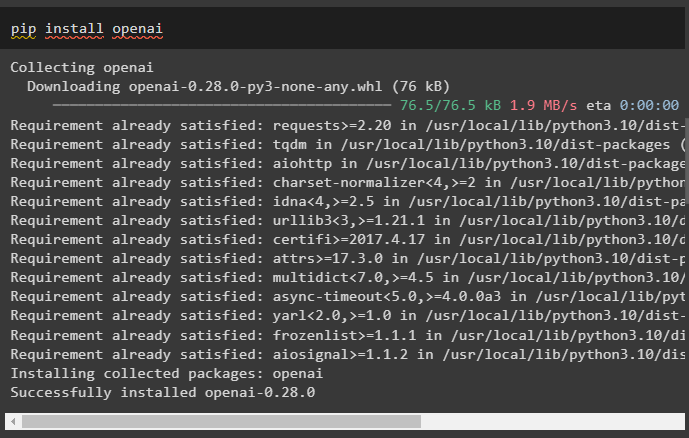

Установите модуль OpenAI, который можно установить с помощью команды pip, чтобы получить библиотеки для построения больших языковых моделей:

pip установить openai

Сейчас, настроить среду используя ключ API OpenAI, который можно сгенерировать из его учетной записи:

Импортировать ты

Импортировать получить пропуск

ты . примерно [ 'ОПЕНАЙ_API_KEY' ] '=' получить пропуск . получить пропуск ( «Ключ API OpenAI:» )

Шаг 2. Использование памяти с LLM

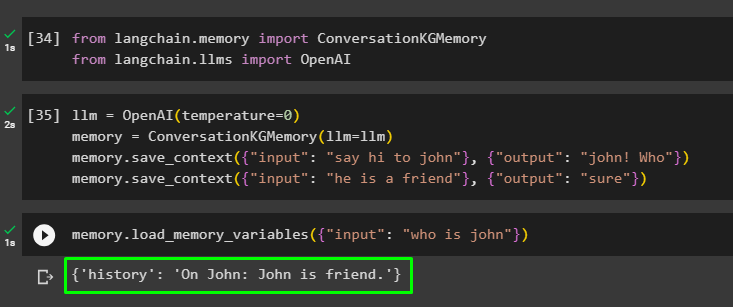

После установки модулей начните использовать память с LLM, импортировав необходимые библиотеки из модуля LangChain:

от лангчейн. Память Импортировать РазговорKGПамятьот лангчейн. llms Импортировать ОпенАИ

Создайте LLM с помощью метода OpenAI() и настройте память с помощью метода РазговорKGПамять () метод. После этого сохраните шаблоны подсказок, используя несколько входных данных, с соответствующим ответом, чтобы обучить модель на этих данных:

лм '=' ОпенАИ ( температура '=' 0 )Память '=' РазговорKGПамять ( лм '=' лм )

Память. save_context ( { 'вход' : «Передать привет Джону» } , { 'выход' : 'Джон! Кто' } )

Память. save_context ( { 'вход' : 'он - друг' } , { 'выход' : 'конечно' } )

Проверьте память, загрузив память_переменные () с использованием запроса, связанного с приведенными выше данными:

Память. load_memory_variables ( { 'вход' : 'кто такой Джон' } )

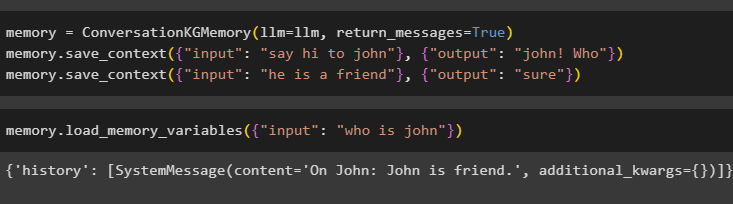

Настройте память с помощью метода ConversationKGMemory() с return_messages аргумент для получения истории ввода:

Память '=' РазговорKGПамять ( лм '=' лм , return_messages '=' Истинный )Память. save_context ( { 'вход' : «Передать привет Джону» } , { 'выход' : 'Джон! Кто' } )

Память. save_context ( { 'вход' : 'он - друг' } , { 'выход' : 'конечно' } )

Просто проверьте память, предоставив входному аргументу его значение в форме запроса:

Память. load_memory_variables ( { 'вход' : 'кто такой Джон' } )

Теперь проверьте память, задав вопрос, который не упоминается в обучающих данных, и модель понятия не имеет об ответе:

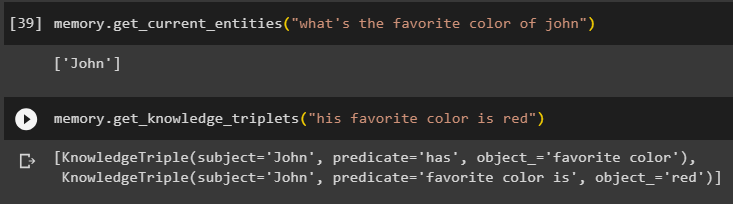

Память. get_current_entities ( «какой любимый цвет Джона» )Использовать get_knowledge_triplets (), ответив на заданный ранее запрос:

Память. get_knowledge_triplets ( «его любимый цвет — красный» )

Шаг 3: Использование памяти в цепочке

На следующем шаге используется память разговоров с цепочками для построения модели LLM с помощью метода OpenAI(). После этого настройте шаблон приглашения, используя структуру диалога, и текст будет отображаться при получении вывода модели:

лм '=' ОпенАИ ( температура '=' 0 )от лангчейн. подсказки . быстрый Импортировать Шаблон приглашения

от лангчейн. цепи Импортировать Разговорная цепочка

шаблон '=' '''Это шаблон взаимодействия человека и машины.

Система представляет собой модель искусственного интеллекта, которая может говорить или извлекать информацию о нескольких аспектах.

Если он не понимает вопроса или не знает ответа, он просто говорит об этом.

Система извлекает данные, хранящиеся в разделе «Конкретные» и не галлюцинирует.

Специфический:

{история}

Беседа:

Человек: {вход}

ИИ: '''

#Настройте шаблон или структуру для предоставления подсказок и получения ответа от системы ИИ.

быстрый '=' Шаблон приглашения ( входные_переменные '=' [ 'история' , 'вход' ] , шаблон '=' шаблон )

разговор_с_кг '=' Разговорная цепочка (

лм '=' лм , подробный '=' Истинный , быстрый '=' быстрый , Память '=' РазговорKGПамять ( лм '=' лм )

)

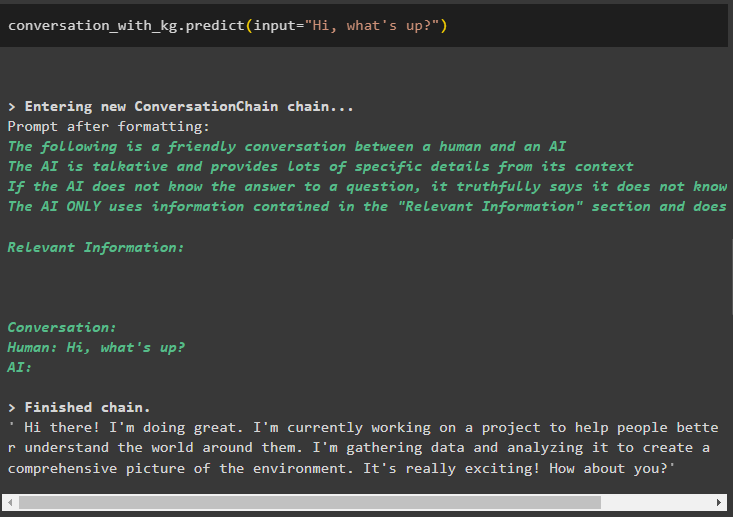

После создания модели просто вызовите разговор_с_кг модель с использованием метода Predict() с запросом, заданным пользователем:

разговор_с_кг. предсказывать ( вход '=' 'Привет как дела?' )

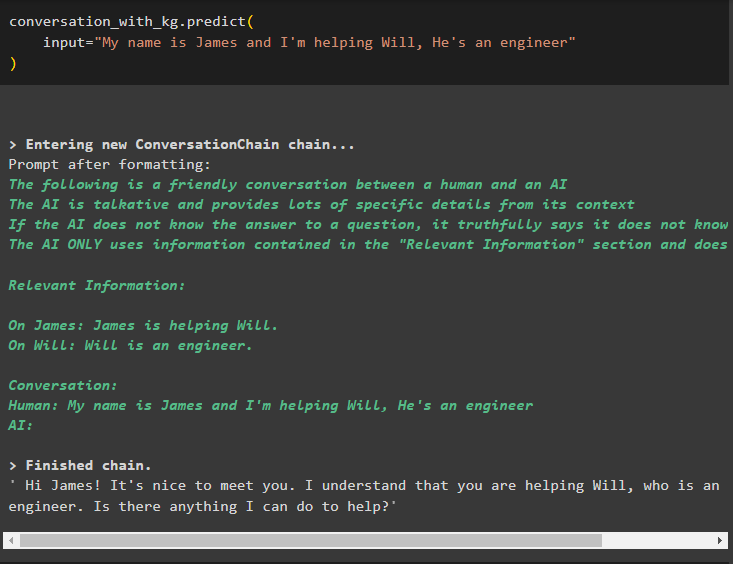

Теперь обучите модель, используя память разговоров, передав информацию в качестве входного аргумента метода:

разговор_с_кг. предсказывать (вход '=' «Меня зовут Джеймс, и я помогаю Уиллу, он инженер»

)

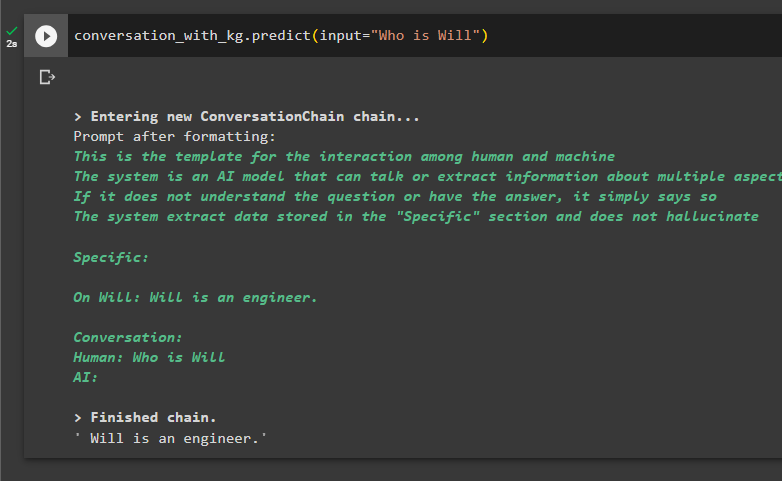

Пришло время протестировать модель, задав запросы для извлечения информации из данных:

разговор_с_кг. предсказывать ( вход '=' 'Кто такой Уилл' )

Это все, что касается использования графа знаний разговоров в LangChain.

Заключение

Чтобы использовать граф знаний диалога в LangChain, установите модули или платформы для импорта библиотек для использования метода ConversationKGMemory(). После этого постройте модель, используя память для построения цепочек, и извлеките информацию из обучающих данных, предусмотренных в конфигурации. В этом руководстве подробно описан процесс использования графа знаний диалога в LangChain.